LA FINE DELLA TEORIA

Il profluvio di dati renderà il metodo scientifico obsoleto?

di Chris Anderson

“Tutti i modelli sono errati, ma alcuni sono utili”

Così affermò George Box 30 anni fa, e aveva ragione. Ma che scelta avevamo? Soltanto i modelli, dalle equazioni cosmologiche alle teorie di comportamento umano, sembravano poter consistentemente, anche se imperfettamente, spiegare il mondo intorno noi. Finora. Oggi le aziende come Google, che si sono sviluppate in un’era di dati sovrabbondanti, non devono accontentarsi di modelli errati. Effettivamente, non devono affatto accontentarsi dei modelli.

Così affermò George Box 30 anni fa, e aveva ragione. Ma che scelta avevamo? Soltanto i modelli, dalle equazioni cosmologiche alle teorie di comportamento umano, sembravano poter consistentemente, anche se imperfettamente, spiegare il mondo intorno noi. Finora. Oggi le aziende come Google, che si sono sviluppate in un’era di dati sovrabbondanti, non devono accontentarsi di modelli errati. Effettivamente, non devono affatto accontentarsi dei modelli.

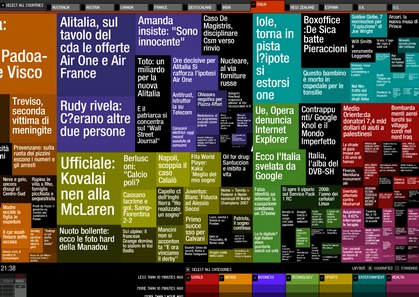

Sessanta anni fa, gli elaboratori digitali hanno reso le informazioni leggibili. Venti anni fa, Internet le ha rese raggiungibili. Dieci anni fa, i primi crawlers dei motori di ricerca hanno reso [Internet] un’unico database. Ora Google e le aziende simili stanno setacciando l’epoca più “misurata” della storia umana, trattando questo corpus voluminoso come laboratorio della condizione umano. Sono i bambini dell’epoca del Petabyte (Petabyte Age).

L’epoca del Petabyte è differente perché il “di più” è differente. I kilobyte sono stati immagazzinati sui dischetti. I megabyte sono stati immagazzinati sui dischi rigidi. I terabyte sono stati immagazzinati nei disc-arrays. I Petabytes sono immagazzinati nella nuvola. Mentre ci siamo mossi lungo quella progressione, siamo passati dall’analogia della cartella (folder) all’analogia dell’archivio all’analogia delle biblioteche a – bene, con i petabyte siamo fuori dalle analogie organizzative.

Alla scala del petabyte, le informazioni non sono una questione di semplici tassonomie a tre e quattro dimensioni e ordini, ma di statistiche dimensionalmente non conoscibili. Richiedono un metodo interamente differente, che ci richiede di lasciar perdere l’idea di poter imbrigliare i dati come qualcosa che possa essere visualizzato nella relativa totalità. Ci costringe in primo luogo a osservare matematicamente i dati, e solo in seguito stabilire un contesto [per la loro interpretazione]. Per esempio, Google ha conquistato il mondo della pubblicità con nient’altro che matematica applicata. Non ha finto di conoscere qualcosa circa la cultura e le convenzioni della pubblicità – ha semplicemente supposto che avere migliori dati, con migliori attrezzi analitici, avrebbe condotto al successo. E Google ha avuto ragione.

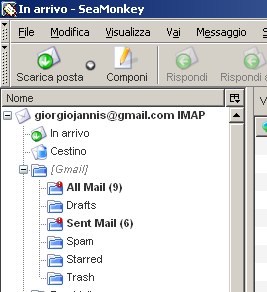

La filosofia fondante di Google è che non sappiamo perché questa pagina è migliore di quellaltra: se le statistiche dei collegamenti ricevuti [incoming links] dicono così, va già bene. Nessun’analisi semantica o causale è richiesta. Ecco perché Google può tradurre le lingue senza realmente “conoscerle” (data un’uguale mole di dati, Google può tradurre facilmente Klingon in Farsi come può tradurre il francese in tedesco). E perché può abbinare gli annunci pubblicitari ai contenuti senza alcuna conoscenza o presupposizioni circa gli annunci o il contenuto.

Parlando alla Conferenza “Emerging Technology” di O’Really questo marzo passato, Peter Norvig, direttore di ricerca di Google, ha offerto un aggiornamento alla massima di George Box: “Tutti i modelli sono errati e sempre più potrete farne a meno [succeed without them]”.

Questo è un mondo in cui le quantità enormi di dati e di matematica applicata sostituiscono ogni altro attrezzo che potrebbe essere applicato. Supplendo a ogni teoria di comportamento umano, dalla linguistica alla sociologia. Dimentica la tassonomia, l’ontologia e la psicologia. Chi sa perché le persone fanno le cose che fanno? Il punto è le fanno, e possiamo seguirli e misurare tutto con una fedeltà senza precedenti. Con abbastanza dati, i numeri parlano da soli.

Tuttavia, il grande obiettivo qui non è la pubblicità. È la scienza. Il metodo scientifico è costruito intorno alle ipotesi verificabili. Questi modelli, per la maggior parte, sono sistemi visualizzati nelle menti degli scienziati. I modelli allora quindi testati e gli esperimenti confermano o falsificano i modelli teorici di come il mondo funziona. Ciò è il modo in cui la scienza ha funzionato per centinaia di anni.

Gli scienziati sono formati per riconoscere che una correlazione non è una causa, che nessuna conclusione dovrebbe essere tratta semplicemente sulla base di una correlazione fra X e Y (potrebbe essere una semplice coincidenza). Invece, devono essere compresi i meccanismi soggiacenti in grado di collegare i due fenomeni. Una volta che avete un modello, potete con una certa fiducia collegare gli insiemi di dati. I dati senza un modello sono soltanto rumore.

Ma dovendo affrontare enormi quantità di dati, questo tipo di approccio scientifico – supposizione ipotetica, modello, test – sta diventando obsoleto. Consideriamo la fisica: i modelli newtoniani erano approssimazioni grossolane della verità (errati al livello atomico, ma ancora utili). Cento anni fa, la meccanica quantistica su base statistica ha offerto una immagine molto migliore – ma la meccanica quantistica è un altro modello e, pur essendo difettoso, è senza dubbio una rappresentazione [caricature] di una realtà di fondo più complessa. La ragione per cui la fisica è andata ricercando nella speculazione teorica grandi modelli n-dimensionali unificati durante le ultime decadi (“la bella storia” di una disciplina affamata di dati) è che non sappiamo fare gli esperimenti che falsificherebbero le ipotesi – le energie sono troppo alte, gli acceleratori troppo costosi, ecc.

Ora la biologia sta puntando nella stessa direzione. I modelli che ci hanno insegnato a scuola riguardo i caratteri “dominanti” e “recessivi” dei geni, che ci conducono verso un processo rigorosamente mendeliano, sono risultato essere una semplificazione ancora maggior della realtà che le leggi del Newton. La scoperta delle interazioni geni-proteine e di altre funzioni della epigenetica ha sfidato la visione del DNA come destino e perfino introdotta la prova che l’ambiente può influenzare le caratteristiche ereditarie, il che era considerato geneticamente impossibile.

In breve, più comprendiamo la biologia, più ritroviamo (interpretiamo) noi stessi da un modello in grado di spiegarla.

Ora esiste un modo migliore. I Petabytes ci permettono di dire: “La correlazione è abbastanza.” Possiamo smettere di cercare nuovi modelli. Possiamo analizzare i dati senza ipotesi circa cosa potrebbero mostrare. Possiamo gettare i numeri nei più centri di calcolo il mondo abbia mai veduto e lasciare che le procedure statistiche trovino i modelli in cui la scienza non può trovare.

Il migliore esempio pratico di questo è il sequenziamento “shotgun” del genoma di J. Craig Venter. Aiutato da sequenziatori a alta velocità e da supercomputer che analizzano statisticamente i dati che redigono, Venter è passato dal sequenziare organismi individuali ad ordinare gli interi ecosistemi. In 2003, ha cominciato a sequenziare gran parte dell’oceano, ritracciando il viaggio del capitano Cook. E in 2005 ha cominciato a sequenziare l’aria. Nel processo, ha scoperto migliaia di specie precedentemente sconosciute di batteri e di altre forme di vita.

Se le parole “scoprire una nuova specie” vi riportano alla mente Darwin e illustrazioni di uccelli, forse siete bloccati nel vecchio senso di fare scienza. Venter può non dirvi quasi niente circa le specie che ha trovato. Non sa a che cosa assomigliano, come vivono, o qual è la loro morfologia. Non ha Neppure il loro intero genoma. Tutto che ha è un segnale di ritorno [blip] statistico – una sequenza unica che, essendo diverso da ogni altra sequenza nel database, deve per forza di cose rappresentare una nuova specie.

Questa sequenza può correlarsi con altre sequenze che assomigliano a quelle delle specie che conosciamo meglio. In quel caso, Venter può fare alcune congetture circa gli animali – ad esempio il fatto che convertano la luce solare in energia in un modo particolare, o che discendono da un antenato comune. Ma oltre a quello, non ha migliore modello di questa specie di quello che Google ha della vostra pagina di MySpace. Sono soltanto dati. Ma analizzandoli con risorse computazionali di qualità-Google, Venter ha fatto avanzare la biologia più di chiunque altro della sua generazione.

Questo genere di pensiero è sul punto di diventare mainstream. In febbraio, il National Science Foundation ha annunciato il Cluster Exploratory, un programma che finanzia ricerca destinata a “girare” su una piattaforma di computazione distribuita a grande scala, sviluppata da Google e IBM insieme con sei università pilota. Il cluster consisterà di 1.600 processori, parecchi Terabyte di memoria e centinaia di Terabyte di archivio, insieme al software, dove saranno compresi Tivoli dell’IBM e versioni opensource del Google File System e MapReduce. I primi progetti di ricerca prevedono simulazioni del cervello e del sistema nervoso e altre ricerca biologiche che si pongono da qualche parte tra il wetware (gli umani) e il software.

Imparare a usare un “calcolatore” di questa scala può essere una sfida. Ma l’occasione è grande: la nuova disponibilità dei gran quantità dei dati, con gli attrezzi statistici per sgranocchiare questi numeri, offre un intero nuovo modo di comprendere il mondo. La correlazione sostituisce la causa e la scienza può avanzare anche senza modelli coerenti, teorie unificate, o senza avere realmente nessuna alcuna spiegazione meccanicistica.

Non c’è motivo di aderire ai nostri vecchi metodi. È tempo di chiedere: che cosa può imparare la scienza da Google?